HubSpot One在2019年為讀者介紹了BERT,另外由於工作關係年前也接觸了不少中文NLP領域傑出的初創企業。當前自然語言處理已經進入了一個高速發展的時期,AI生成的文章(NLG)、AI輔助生成的文章、AI編輯的影片將會更多滲透到普通人的生活中。在不久以後你每天消費的內容中可能有相當的比例會是由AI製作的。

美庫爾DWA的Krish Sailam在AdExchanger上的評論文章《As AI Use Expands, We Need Standards To Identify Content Not Created By Humans》可以說是2020年來對AI內容的問題看得最透徹的文章之一。 Sailam非常直接地表達了對AI產生內容的擔憂,主要圍繞著三個方面:

- 現有科技能否有效識別AI參與製作的內容

- 對於AI製作的內容,其版權的歸屬問題

- 利用AI製作內容的媒體是否應該主動標識AI內容

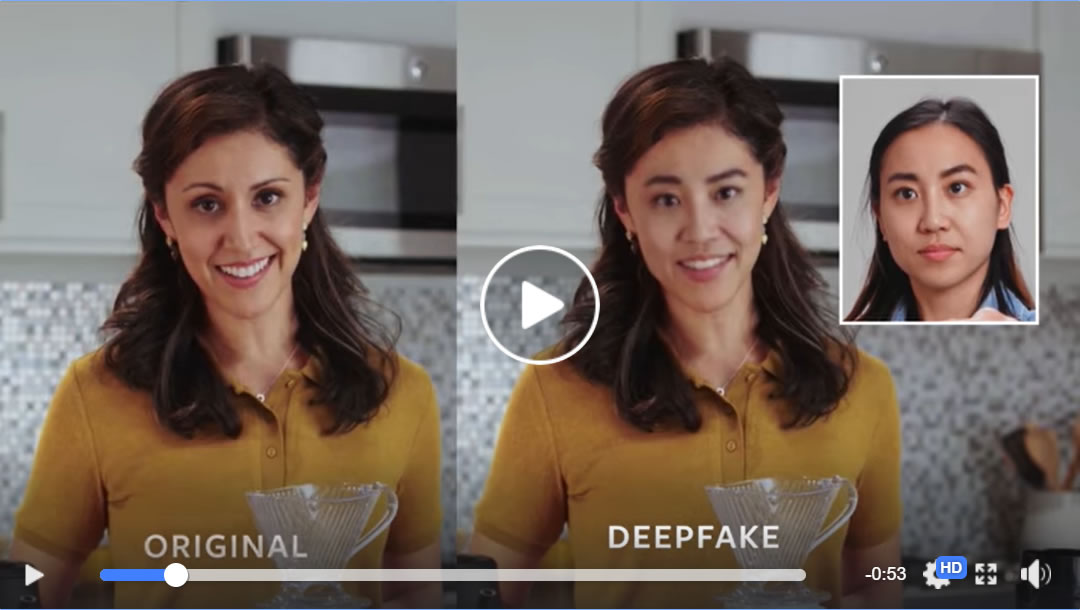

AI製作內容存在著多種形式。有同義詞替換語序顛倒的“偽原創”文本,也有海量爬蟲拼湊的新內容,還有我們聽習慣的林志玲導航,更有像DeepFake那樣去年成為話題的換臉影片。您可以點擊這裡體驗一下AI主播播報新聞,也可以點這裡聽川普對你科普。

現有的科技對於識別這些人工智能產生的內容並沒有像生成這些內容那樣容易,這也是為什麼Facebook、微軟、MIT、康奈爾大學、伯克利大學、馬里蘭大學、牛津大學等等一道為了DeepFake要搞一個Deepfake Detection Challenge (DFDC)。因為AI真的可以達到以假亂真的程度。

去年年底,Google地圖就推出了導航語音定制功能。用戶只需在Google地圖App上錄製20句話,20分鐘左右即可生成個人完整語音包。整個過程非常有趣,但是如果這個語音包被用於你的長輩會發生什麼?我們可以想像一下最壞的結果是什麼。更糟糕的是今後我們所謂的錄音證據、影片證據將迅速失效。

我們通常理解的AI產生的內容是沒有版權的,但是如果其不被標註由AI製作而被署以人名或者無署名那麼就變成自然人的作品。把比如搜索引擎結果頁面是機器編篡而成的,因為我們知道它是自然排名而不是人為編輯所以不會構成侵權問題。不作AI標識會存在很大法律風險。

另外在本已版權意識淡薄的市場中,偽原創、抄襲、洗稿氾濫,再加以更大量級的機器人寫的垃圾,這會讓人們尋找真正有用的訊息變得越發困難。在一些媒體中出現的內容我們實在無法有效辨別,有時候讀到一半才發現是機器人寫的,有時讀完了也沒有發現有用訊息,有的甚至會斷章取義變成謠言。這將變成實實在在的一場訊息災難。

那麼為什麼會有那麼多垃圾AI內容呢?媒體需要負很大責任,其次是搜索引擎,最後是品牌。正是因為追求廉價內容,添加新的廣告庫存,媒體才會熱衷於用AI製造新內容。這些內容往往無引用無背書,普遍低質量。搜索引擎的問題是在技術上無法真正識別原創作品和自然人作品,這給許多不良媒體創造了溫床。

如果說媒體存在原罪,搜索引擎實力不濟,那麼品牌的問題便是愚昧。如果老PR人的思維是天天見報還是比較靠譜的,那麼數字行銷中的PR人刷發文數、閱讀量則是完全沒有開化的狀態,因為有更多的機器人內容被機器人閱讀了。

因此,如Sailam所說,整個媒體行業和廣告傳播界實在需要進行自律。如果我們自己管不了自己,那麼總會有人來管,而屆時我們要付出的代價可能比突然失去第三方Cookie要慘重得多。劣幣驅逐良幣,之後還有誰來辛苦碼字呢?